Każda aktualizacja Google ma swoich zwycięzców i przegranych, algorytm aktualizacji wiąże się z dużą ilością niespodzianek. Ze względu na to, że przez lata aktualizacje postępowały i ewoluowały, Google zdobyło niespotykaną kontrolę i wnikliwą wiedzę na temat swoich indeksów, przez co z naszej perspektywy niemożliwym jest zrozumienie czy przewidzenie w jakim stopniu te aktualizacje zmienią rankingi i dynamikę organicznego umiejscowienia.

Pierwsze oznaki tego, że Google zamierza zamieszać w świecie SEO pojawiły się w marcu , kiedy Danny Sullivan z SearchEngineLand.com stwierdził:

“Nie mówiono dużo o tej aktualizacji, prawdopodobnie dlatego, że nikt tak naprawdę nie wiedział, co się dzieje”.

Wielu ekspertów wierzy, że omawiana aktualizacja to diaboliczne połączenie swoich poprzedników, Pandy i Pingwina. Wielu obserwatorów zauważyło strony odnotowujące znaczącą obecność reklam, które spadły w rankingu. W oparciu o empiryczne dowody mogłoby się wydawać, że właśnie to było celem tej aktualizacji. W rzeczywistości wiele mniejszych stron bez dużej ilości reklam również znacznie ucierpiało, mówimy o prostych, „skromnych” stronach, dla których organiczne rankingi to chleb powszechni. Te strony straciły od 10 do 30 pozycji w odniesieniu do swoich „kluczowych zarabiających fraz”, co ostatecznie doprowadziło do konwersji. Żadne z nich nie zdradzały jawnych oznak z punktu widzenia SEO.

Celem tego postu jest zaoferowanie wglądu i przedstawienie czynności naprawczych, które mogą pomóc podnieść się po aktualizacji algorytmu Fred.

A więc spadłeś w rankingu po aktualizacji Google o nazwie Fred – co teraz?

Zacznij od swojego profilu linków zwrotnych korzystając z Majestic.

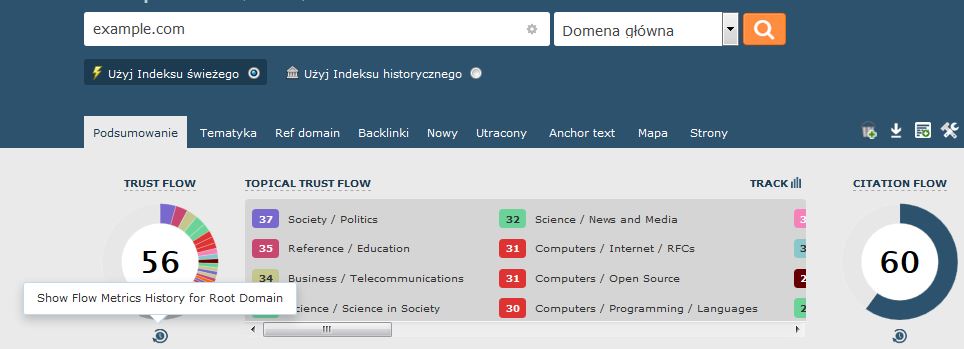

W panelu logowania otwórz Site Explorer. Jak widzisz na zdjęciu powyżej, masz dostęp do historycznych danych Metryki Przepływu. Tutaj możesz sprawdzi, czy doszło do jakiś znaczących zmian w zakresie twojego Przepływu Zaufania, które mogły mieć wpływ na poważne zmiany dotyczące rankingu w okresie ostatnich 18 miesięcy.

Jeśli taki przegląd nie zapewni żadnych interesujących danych, możesz zawsze wykonać inny test korzystając z Majestic:

- Otwórz Site Explorer

- Stwórz raport (po Angielsku) za pomocą zaawansowanych opcji

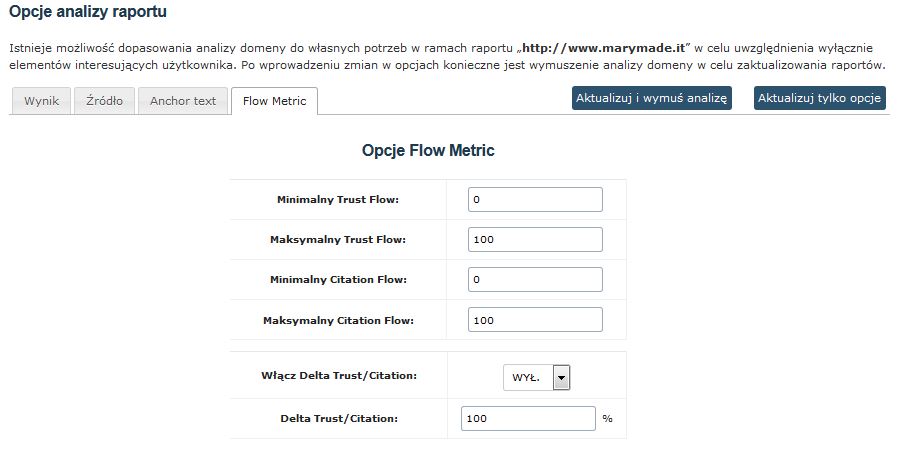

Z działu Raport, przejdź do Opcji dotyczących analizy

Stąd, przejdź do sekcji Metryki przepływu

Ustaw Zaufanie Delta/Cytowanie na: Max

Ustaw maksymalną wartość pomiędzy Przepływem zaufania a Przepływem cytowania na 10%

Przeprowadź nową analizę i pobierz profil linku zwrotnego.

Teraz masz listę wszystkich linków z bardzo niską wartością Przepływu zaufania w porównaniu z Przepływem cytowania. To typ linków, które zazwyczaj powodują problemy, jednakże tylko bardzo doświadczony SEO może określić czy takie linki są toksyczne czy nie.

W zależności od wyniku twojej pierwszej analizy, może okazać się, że trzeba będzie zwiększyć stosunek Zaufania/Cytowania i doprowadzić go do 20% oraz przyjrzeć się dodatkowym linkom o niskiej jakości.

Analiza “na miejscu”

Krótka lista poniżej wystarczy do tego, aby określić najważniejsze czynniki, które trzeba ocenić w celu odzyskania rankingów utraconych za sprawą Fred. Kiedy już poznasz krytyczne sfery, musisz zabrać się do roboty… Przyznam, że te rady mogą się wydawać oczywiste z perspektywy specjalisty zajmującym się SEO, ale wszystkie strony, które sprawdziłem prezentują podobne wzory i reagowały w pozytywny sposób (znaczący wzrost w rankingu w okresie od 2 do 3 tygodni).

Konsola wyszukiwania Google

Tu powinieneś zacząć. Napraw wszystkie błędy zgłoszone przez Konsolę Wyszukiwania Google w dziale Ulepszenia HTML:

- Czy istnieją jakieś duplikaty TYTUŁÓW/OPISÓW META?

- Czy istnieją TYTUŁY/OPISY META, które należy skrócić?

Te błędy wymagają natychmiastowej uwagi – takie modyfikacje to świetny punkt początkowy, ponieważ wysyłają Google sygnał, że potraktowałeś poważnie optymalizację twojej strony (zauważ fakt, że celowo unikam użycia słowa penalizacja).

Sprawdź dział Dane strukturalne: nawet jeśli obecnie nie korzystasz z żadnych danych tego typu, możliwym jest znalezienie jakiś błędów wygenerowanych przez twój CMS (zdarza się to często w przypadku WordPress). Powinieneś także podjąć pozytywne działania i usunąć kod, który generuje błędy Danych strukturalnych.

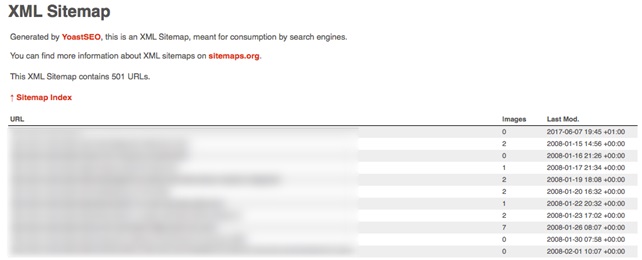

Zweryfikuj mapę swojej strony sprawdzając czy jest regularnie aktualizowana? Zakładam, że twoja strona generuje mapę strony – jeśli takiej nie stworzyłeś, musisz zrobić to natychmiast! Na tym etapie musisz być bardzo ostrożny: twoja mapa strony powinna być aktualizowana regularnie i oferować wyszukiwarkom parametr LASTMOD.

Jeśli korzystasz z WordPress, zalecam zastosowanie tej funkcjonalności, do której można mieć dostęp za pośrednictwem wtyczki YoastSEO.

Dlaczego LASTMOD jest ważny

LASTMOD zapewnia wyszukiwarkom kompletną listę wszystkich stron. Bardziej szczegółowo, zapewnia informacje odnoszące się do tego, jakie strony były ostatnio aktualizowane i, w ten sposób, jakie strony należy wyszukiwać: bez tego kluczowego parametru wyszukiwarki będą musiały zgadywać, które strony były ostatnio wyszukiwane. LASTMOD zapewnia wyszukiwarkom kluczowe informacje potrzebne do optymalizacji budżetu wyszukiwania).

Optymalizacja obrazu

To zazwyczaj słaby punkt. Każdy obraz można optymalizować – podać wymiary obrazu i TAGI ALT!

Zweryfikuj architekturę strony

Zawsze sprawdzaj numer stron zaprezentowanych w Indeksie Google poprzez korzystanie z specjalnego operatora na stronie. Przeprowadź pełen skan strony korzystając z narzędzi takich ScreamingFrog i porównaj dane – jeśli odkryjesz znaczące rozbieżności pomiędzy wyszukiwaniem ScreamingFrog a liczbami przedstawionymi przez site:command, potrzeba bardziej wnikliwej analizy, aby zidentyfikować i wyeliminować niepotrzebne strony, które Google objęło indeksem.

Test prędkości

Prosty test prędkości może ujawnić ważne informacje o wynikach strony, co będzie mieć wpływ na rankingi twojej strony.

Przemyślenia na temat Fred, aktualizacji

Jeśli twoja strona straciła dużo ruchu po aktualizacji Google i zbadałeś ten temat, znajdziesz wiele „eksperckich” opinii oferujących sprzeczne wnioski i sugestie, dotyczące tego, jak można naprawić sytuację: jeśli spytasz 10 ekspertów z dziedziny SEO, otrzymasz 10 różnych opinii. Wiedząc o tym, nie jestem wyrocznią, jeśli chodzi o SEO, skonfrontowałem moje pomysły z kilkoma zaufanymi kolegami z branży przed zaangażowanie się w jakiekolwiek akcje zbiorowe. Ja także zetknąłem się z pokaźną liczbą opinii i pomysłów: niestety, z reguły są one odbiciem osobistego doświadczenia, specjalizacji i historii danej jednostki.

To nieprawda, że posty z przynajmniej 500 słowami trafiają na pierwszą stronę Google.

Ponieważ Fred jest postrzegany jako niegodziwe połączenia Pingwina i Pandy, niektórzy kłócą się, że strata rankingów wynika z faktu, iż posty na stronie są do siebie „zbyt podobne”, przez co strona zostaje oznakowana jako strona o słabej treści. Każda strona jest inna, dlatego w każdy przypadek należy rozpatrzyć oddzielnie. Niestety, nie ma uniwersalnego rozwiązania. Są przypadki stron, gdzie nie ma zastosowania ogólna zasada: na przykład strony z wieloma obrazami.

Ranking i reklamowanie wyszukiwań wykazują Silną synergię

Mamy dwie strony tego samego medalu: jeśli rankingi organiczne zaczynają się pogarszać, ucierpi na tym także płatne wyszukiwanie. W jasny sposób pokazały to dane, które zebrałem po pierwszym wypuszczeniu Fred – kolejny powód, aby zainwestować w organiczne umiejscowienie i optymalizację strony.

Media społecznościowe nie kompensują braku SEO i reklam wyszukiwania

W przypadku tych stron, które ucierpiały ze względu na Fred, po zaobserwowaniu spadku wizyt wygenerowanych przez SEO, powstały nowe i alternatywne kanały w mediach społecznościowych. Segmentacja i charakterystyka odbiorców musiała być skrupulatna. Media społecznościowe w rzeczy samej wygenerowały wiele konwersji; jednakże te konwersje nie wyprodukowały tego samego poziomu osobistego zainteresowania jak widać to w przypadku kontaktów, które powstają za sprawą SEO/SEA. Wierzę, że sprawa przedstawia się dość prosto: ludzie szukają pomocy wyszukiwarek ponieważ poszukują czegoś konkretnego lub próbują rozwiązać problem. Ludzie, którzy korzystają z mediów społecznościowych są często nieskupieni i w bardziej zrelaksowanym nastroju czy stanie umysłu. Dosyć często różnica w jakości kontaktów jest tak silna, że można rozróżnić kontakt, który powstał w oparciu o media społecznościowe analizując wyłącznie sposób, w jaki napisano zaproszenie.

Chcesz klasyfikować organicznie? Musisz na to zapracować!

Odratowałem kilka stron, które zsunęły się na trzecią stronę wyszukiwania w Google ze względu na „monetarne słowa kluczowe” po aktualizacji Fred i nie było to łatwe zadanie. Te strony miały wcześniej dobrą pozycję i dominowały w SERP od dłuższego czasu. Przetrwały także poprzednie aktualizacje algorytmu Google. Przywracanie ich do poprzedniego stanu wiązało się z olbrzymim wysiłkiem, aby pokonać braki wykryte w różnych strefach na stronie, o których wspomniano w tym poście.

Przesłanie jest jasne: jeśli marzą ci się rankingi organiczne, musisz zademonstrować, że zasługujesz na najwyższą pozycję, zajmując się WSZYSTKIMI STREFAMI: nie warto starać się na pół gwizdka. W skrócie właśnie o to chodzi w aktualizacji Fred.

Wszystko co jest opisane dotyczy w gównej mierze Fantoma. Poza tym NPROFIT jasno napisał, że to nie jest Fred.

Więc jak chcesz się odbić w rankingu zapomnij o Fredzie, zrób analize pojedynczych podstorn pod kątem Fantoma (szczególnie treści, pandy) i się wyliżesz.

July 19, 2017 at 3:35 pmCześć, Nie znam źródła, o którym wspominasz, ale wierzę w Twój osąd na temat ich analizy. Moją opinię opieram na tym, co widzę i jak sytuacja się rozwija, a także kiedy dokładnie się to się dzieje.

July 27, 2017 at 2:28 pmW moim poście podkreśliłem jak skomplikowane stały się przesunięcia w rankingach i jak niemal niemożliwe jest pełne zrozumienie co się dzieje.

Jak mówisz, aby odbudować ranking, nie możemy przeprowadzić dokładnej analizy, ale spróbować naprawić rzeczy, które widzimy, że są nie prawidłowo zrobione oraz wprowadzić nowe zmiany o których wiemy, że działają dobrze.

Uważam, że masz rację, kiedy mówisz "zapomnij o Fredzie" – dodałbym "zapomnieć o aktualizacjach algorytmu" i trzymać się tego co opisałem: Organic jest trudnym biznesem, musisz ciężko pracować, aby zdobyć pozycje.

dzięki za art., nurtuje mnie jeszcze jedno pytanie, kiedy już będę miał listę linków, które są niskiej wartości to co z nimi dalej?

July 20, 2017 at 2:08 pmPrzede wszystkim chcesz utworzyć plik disavow i uwzględnić w nim wszystkie domeny (nie konkretne adresy URL). Uważaj na identyfikację "toksycznych" linków. Jeśli masz taką możliwość, zlikwiduj je całkiem, ale to prawie nigdy nie będzie możliwe. Oto wskazówka: utwórz stronę z wspomnianymi toksycznymi linkami i pozwól to zaindeksować Google.

July 27, 2017 at 2:26 pmRóżnica jest zauważalna po zmianie algorytmu. Czy na im plus czy minus nie będę mówił publicznie, ale jest diametralna. Na kluczowych frazach zmiany, ale na mniej obleganych praktycznie nie widać różnicy. Dobre wprowadzenie autora, że przy każdej zmianie są zwycięzcy i trochę ci, którzy przygrywają. Najlepiej jest nie kombinować i w sposób naturalny dbać o pozycjonowanie w Googlach. Wszędzie jest konkurencja, ale często wystarczy kilka prostych zabiegów, aby wpaść na stałe do top 10. Pozdrawiam, Kamil z Bieganie Uskrzydla [EDIT: LINK REMOVED]

September 7, 2017 at 6:59 pmU mnie widać sporą różnicę, na plus. Na kilka fraz kluczowych związanych z moją stroną zanotowaliśmy mocny przyrost pozycji i weszliśmy na części fraz dla nas istotnych, a dla których ciężko było się nam dostać, wpadliśmy do pierwszych top10. Jak wszędzie, są plusy i minusy zmiany wyliczania algorytmu. Tym razem udało się wywalczyć coś więcej a innym razem będzie lekki spadek. Działamy dalej. Dzięki za blog! Pozdrawiam, Kamil

September 8, 2017 at 9:29 am