W wynikach wyszukiwania pojawią się podstrony, które Twoim zdaniem nie powinny? Jest wiele sposobów, aby się ich pozbyć.

Powodów, dla których nie chcesz, aby podstrony Twojego serwisu były wyświetlane w wynikach wyszukiwania może być wiele, oto najpopularniejsze z nich:

- na stronach pojawiają się poufne treści, których nie chcesz pokazywać użytkownikom

- posiadasz testowe strony, które jeszcze nie są do końca dopracowane

- podstrony zawierają błędy 404, są nieaktualne

- podstrony duplikują się lub kanibalizują – dwie lub więcej podstron dotyczą tego samego, dopasowane są do tych samych słów kluczowych

- indeksują się podstrony związane ze stronicowaniem, logowaniem, rejestracją, konwersją (Thank You Page), sortowaniem i filtrowaniem

5 sposobów na wyindeksowanie podstron

1. Noindex Nofollow

Najskuteczniejszym sposobem na zablokowanie przed indeksacją podstron jest umieszczenie w jej kodzie HTML metatagu Noindex. Odnaleziony przez roboty tag wyeliminuje stronę z wyników wyszukiwania.

Tag należy dodać w sekcji <head> strony:

<meta name=”robots” content=”noindex, follow”>

lub

<meta name=”robots” content=”noindex, nofollow”>

Pierwsza z opcji wyindeksuje podstronę jednak umożliwia robotom przechodzenie przez podstronę do kolejnych linków, druga zablokuje również crawlowanie.

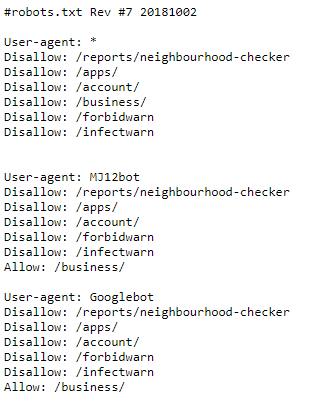

2. Zablokowanie podstron w pliku robots.txt

Plik robots.txt umożliwia zablokowanie renderowania poszczególnych podstron lub grup podstron posiadających wspólne elementy w adresie URL.

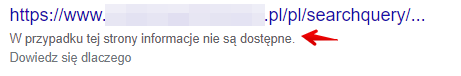

Tworzenie pliku robots.txt jest procesem, o który warto zadbać już na początku budowania strony. Blokując dostęp robotów do podstron możesz sprawić, że nie dotrą one do treści, których nie chcesz wyświetlać. Działanie podjęte na etapie budowania strony lub powstawania nowych podstron może pomóc w uniknięciu problemów w przyszłości. Warto jednak pamiętać, że zablokowanie ich w pliku robots.txt nie daje gwarancji, że Google do nich nie dotrze i nie zostaną zaindeksowane. W przypadku zaindeksowania wyglądają one w wynikach wyszukiwania w ten sposób:

Przykład wyników zaindeksowanych lecz zablokowanych w pliku robots.txt

Plik robots.txt jest ogólnodostępny, oznacza to, że każdy użytkownik wpisując twoją domeną z końcówką /robots.txt może zobaczyć jego zawartość.

Nie należy w nim zamieszczać adresów do podstron, których nie powinien nikt zobaczyć.

Przykładowy plik: pl.majestic.com/robots.txt

UWAGA! Jeżeli posiadasz adresy które zostały już zaindeksowane dopisanie ich do pliku robots.txt nie sprawi, że zostaną usunięte z Google. Umieszczenie ich w pliku może nawet uniemożliwić ich wyindeksowanie. Roboty Google nie zobaczą dodanego na nich znacznika Noindex.

3. Plik .htaccess

Plik .htaccess pozwala na zablokowanie witryny nie tylko przed robotami Google i zaindeksowaniem, ale również blokuje dostęp do strony użytkownikom.

Jeśli dopiero pracujesz nad stroną i jest ona roboczą wersją najlepszym rozwiązaniem jest skorzystanie z pliku .htaccess lub .htpasswd, dzięki któremu witryna będzie dostępna po wprowadzeniu hasła.

4. Linki kanoniczne

Dzięki odpowiedniemu wdrożeniu linków kanonicznych możesz wskazać robotom Google, które adresy chcesz aby były indeksowane, a które niekoniecznie.

Wdrożenie linków kanonicznych szczególnie sprawdza się w przypadku duplikacji lub kanibalizacji.

Jeżeli na Twojej stronie pojawiają się takie same treści i słowa kluczowe na dwóch różnych podstronach możesz przy pomocy linków kanonicznych wskazać, który z nich powinien być brany pod uwagę przez roboty Google i pojawiać się w wynikach wyszukiwania.

Dokładna instrukcja dotycząca wdrożenia linków kanonicznych pozwala na uniknięcie błędów.

Na stronie warto wdrożyć linki kanoniczne nawet jeśli nie pojawiają się duplikaty. Wówczas zastosować należy linki 1:1 tj: Dla podstrony https://www.domena.pl/podstrona linkiem kanonicznym będzie adres: https://www.domena.pl/podstrona – ten zabieg pomoże w indeksacji prawidłowych adresów.

Tak jak w przypadku pliku robots.txt jest to jedynie sposób sugerowania robotom adresów, których nie chcemy indeksować. Może zdarzyć się, iż pomimo wdrożenia linku kanonicznego do innej strony adres zostanie zaindeksowany.

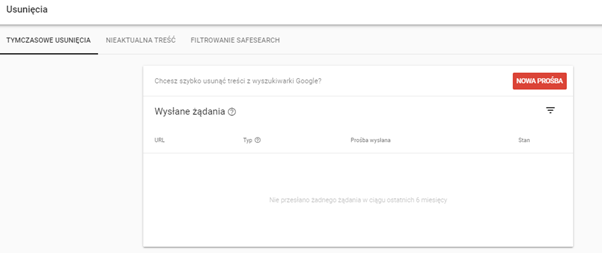

5. Zakładka Usuwanie w Google Search Console

Od 28 stycznia 2020 w narzędziu Google Search Console w zakładce Usunięcia mamy również możliwość zgłoszenia adresów, które chcemy usunąć z wyników wyszukiwania:

Narzędzie umożliwia usunięcie pojedyńczego adresu URL lub wszystkich adresów zawierających określony prefiks.

Tymczasowe usunięcie pozwala na pozbycie się strony z indeksu na 6 miesięcy, natomiast Usunięcie adresu url z pamięci podręcznej wyrzuci adres z indeksu, aż do ponownego zaindeksowania.

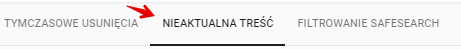

Search Console daje również możliwość zgłoszenia nieaktualnych treści przez narzędzie Removals – dzięki niemu masz możliwość usunięcia adresów z indeksu, nawet jeżeli nie masz dostępu do GSC – prośby są akceptowane najczęściej w przypadku błędów 404. Jeżeli ktoś (lub Ty sam) zgłosi w narzędziu adres Twojej witryny dostaniesz taką informację w zakładce Nieaktualna treść.

Artykuł opracowała:

Klaudia Hadała, SEO Specialist w DevaGroup – Pozycjonowanie i Google Ads

- Kontynuuj działania z funkcją Ostatnia Aktywność! - April 4, 2023

- Budowa wizerunku eksperta z wykorzystaniem zasad SEO - March 13, 2023

- Linkowanie wewnętrzne – jak robić to mądrze? - March 9, 2023